博士3年の寺田君,修士2年の倉田君,修士1年の志田原さんが,北九州市で開催されたIEEE Global Conference on Consumer Electronics (GCCE2024)で以下の研究成果の発表を行いました.このうち志田原さんの研究がExcellent Poster Award (Silver Prize)を受賞しました(約160件中の2位).

- Kandai Kurata, Airi Tsuji, and Kaori Fujinami, “Uh-Huh Duch: Self-Problem-Solving Support During Programming Through Interaction with a Doll Duck,” In Proceedings of the 2024 IEEE 13th Global Conference on Consumer Electronics (GCCE 2024), pp. 689-690, 30 October 2024.

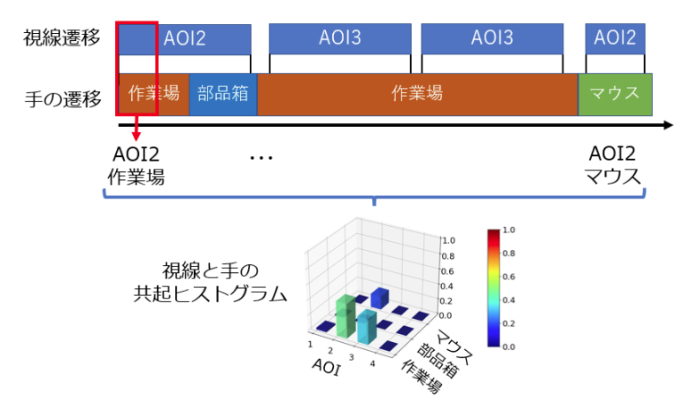

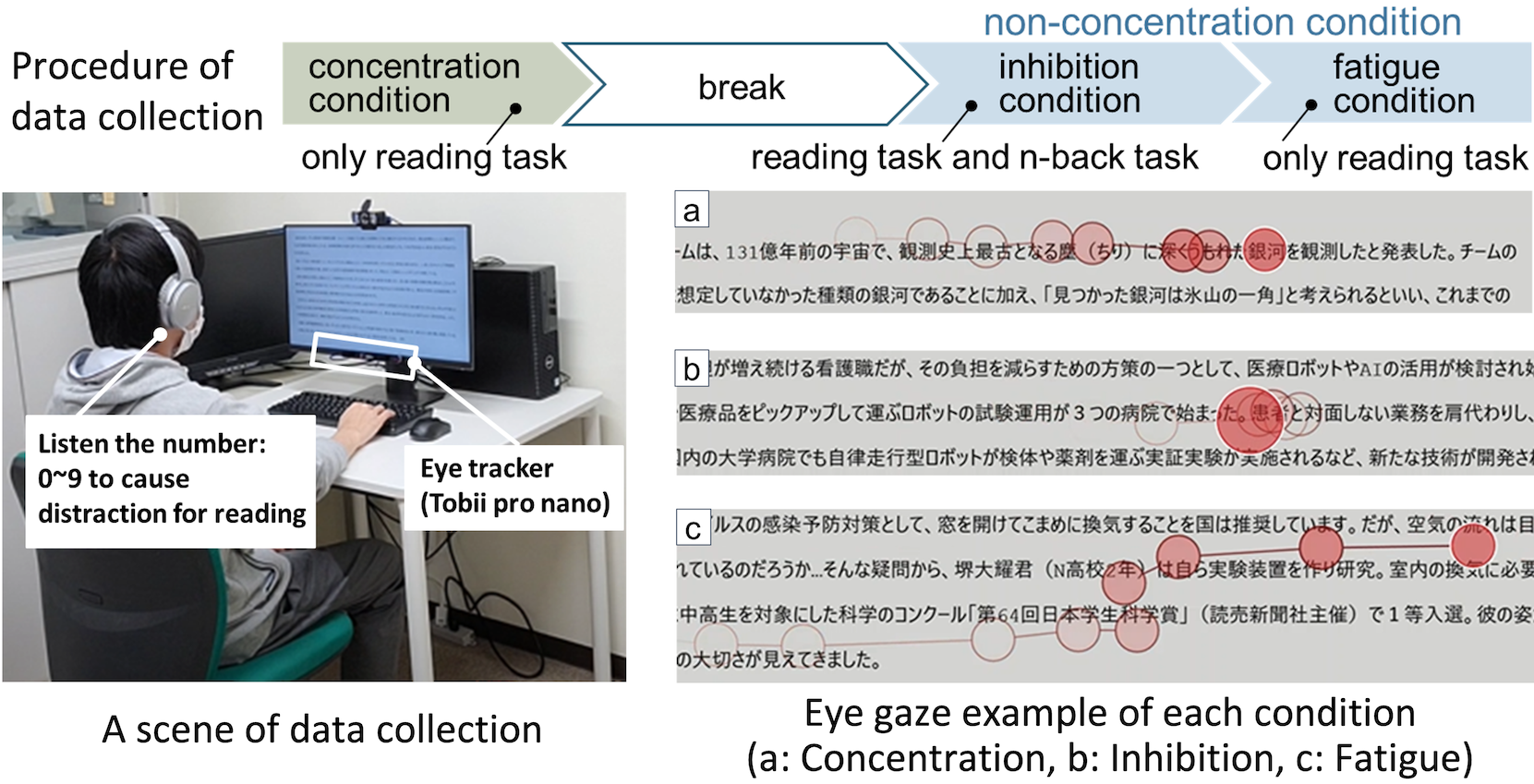

- (Silver Prize of Excellent Poster Award) Moemi Shidahara, Airi Tsuji, and Kaori Fujinami, “A Preliminary Study on Mental Workload Estimation Through Movement Analysis Using Inertial Sensors: A Case of Floor Mopping”, In Proceedings of the 2024 IEEE 13th Global Conference on Consumer Electronics (GCCE 2024), pp. 146-147, 29 October 2024.

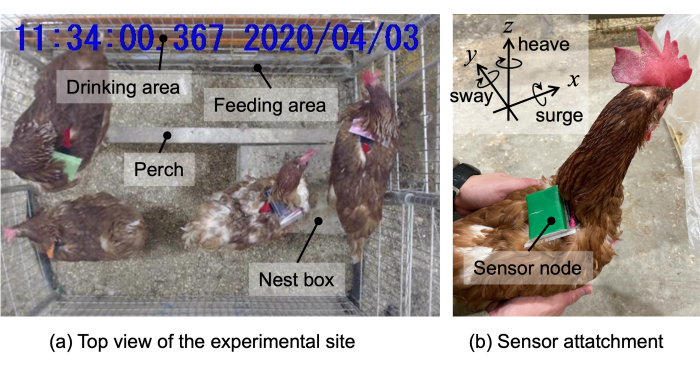

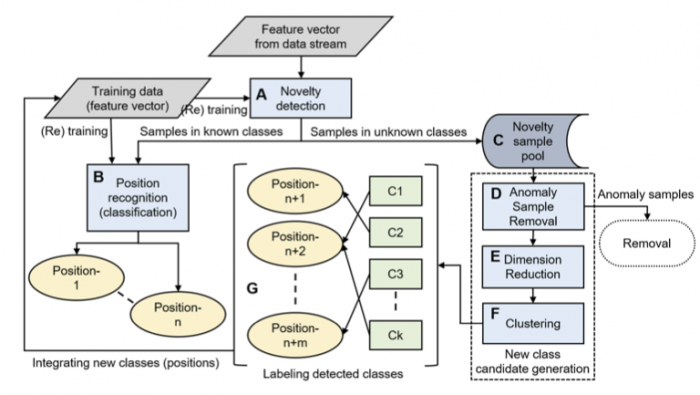

- Kenji Terada and Kaori Fujinami, “Improving Disease Forecast on Different Farms Using Sensing Agricultural Robot with XAI”, In Proceedings of the 2024 IEEE 13th Global Conference on Consumer Electronics (GCCE 2024), pp. 411-415, 29 October 2024.