当研究室20期生となる3年生6名が配属されました(伊佐 堅太郎,下垣 航生,鈴木 海紗南,田島 和展,能登 康太,林田 芳夏).

投稿者: tuat-dlcl

対外発表(UBI87)

富山県富山市で9/17,18に開催された情報処理学会MBL/UBI/ASD/CDS研究会の合同発表会において以下の4件を発表しました(下線は発表者).日中は研究,夜は富山県の名産を堪能しました.

- 志田原萌美,藤波香織.ドメイン適応を用いたユーザ特化手法の検討〜床拭き掃除時の認知負荷推定のケース.

- 岩本純,瀬口瑛子,新村毅,藤波香織.烏骨鶏家族の社会関係分析に向けた位置情報活用の検討.

- 矢野明日香,藤波香織.コンテキストを考慮したVR体験中の実世界アウェアネス支援.

- 百合草優伽,辻愛里,藤波香織.同調的で親近感を与える実世界投影型エージェントによる思い出振り返り支援.

研究室旅行@那須高原

7月18日から20日にかけて,2泊3日で栃木県那須高原に旅行に出かけました.アスレチックや創作体験,バーベキューなどを通じて親睦を深めました.

対外発表・受賞(DICOMO2025)

福島県母畑温泉で開催された情報処理学会 マルチメディア,分散,協調とモバイルシンポジウム(DICOMO 2025)にて下記の2件の発表を行い,志田原さんが優秀プレゼンテーション賞を受賞しました.

- 高野耀希,長瀬清之助,辻愛里,藤波香織.能動学習を活用した組み立て作業中の迷い推定システムの個人化,マルチメディア,分散,協調とモバイルシンポジウム(DICOMO2025),pp. 497-507, 2025年6月25日.

【概要】近年,製造現場では手作業の組み立て作業を情報技術で支援する有用性が示されていますが,作業者の状態を無視した支援は意欲低下を招くという報告があります.我々の先行研究で,作業者の状態として視線と手の位置による迷い推定手法を提案し,個人化モデルが推定精度向上に有効であることを示唆しました. この発表では迷い推定システムの個人化手法として能動学習に着目し,推定精度への個人差の影響低減を目指しました.また,状態に応じた支援設計に関する知見を得るため,システム長期使用時のユーザビリティや作業者への影響を定量的に評価しました.結果として,能動学習による個人差の影響低減は確認されず,適切な特徴量・分類モデルの再選定が必要であることが分かりました.さらに,推定結果提示のユーザへの影響やシステムの改善点も明らかにしました.

- 志田原萌美,藤波香織.装着型慣性センサを用いた作業時のメンタルワークロード推定〜床拭き掃除のケース〜,マルチメディア,分散,協調とモバイルシンポジウム(DICOMO2025),pp. 748-758, 2025年6月26日.

【概要】ワーキングメモリにかかる認知負荷量をメンタルワークロード(MWL)といい,過負荷時には注意力の散漫によりヒューマンエラーが発生しやすいとされます.また,慢性的な負荷が食欲の増加や睡眠の質に影響することが分かっており,ヘルスケアに影響する可能性もあります.そこで日々のMWLの推定やリアルタイムかつ客観的な推定が重要となります.本研究では床拭き掃除をケーススタディとして,その最中の身体と道具の慣性データによるMWL推定手法を検討しました.我々の先行研究では,固定長時間区間(ウィンドウ)内のデータから平均や分散,周波数成分の算出した基本特徴量を用いた推定の有効性を確認していましたが,本発表では記号列特徴量と呼ぶ新たな特徴量を導入してその単体の有効性や基本特徴量との組み合わせの有効性を検証しました.記号化特徴量は,慣性センサの生データから算出した多次元情報をベクトル量子化により変換した記号列に対して,記号間の遷移や出現頻度などを算出して特徴量とするものです.基本特徴量と記号化特徴量の統合により推定精度が最も向上することを確認しました.また特徴量の算出時間の点からは,基本特徴量のみを用いることが良いことを実験的に示しました.

受賞(情報処理学会 全国大会 大会優秀賞)

2025年3月に情報処理学会第87回全国大会にて発表した倉田君と百合草さんの発表が,ベストペーパー賞に相当する大会優秀賞を受賞しました(全発表の中の上位10件に授与).(学会ホームページ)

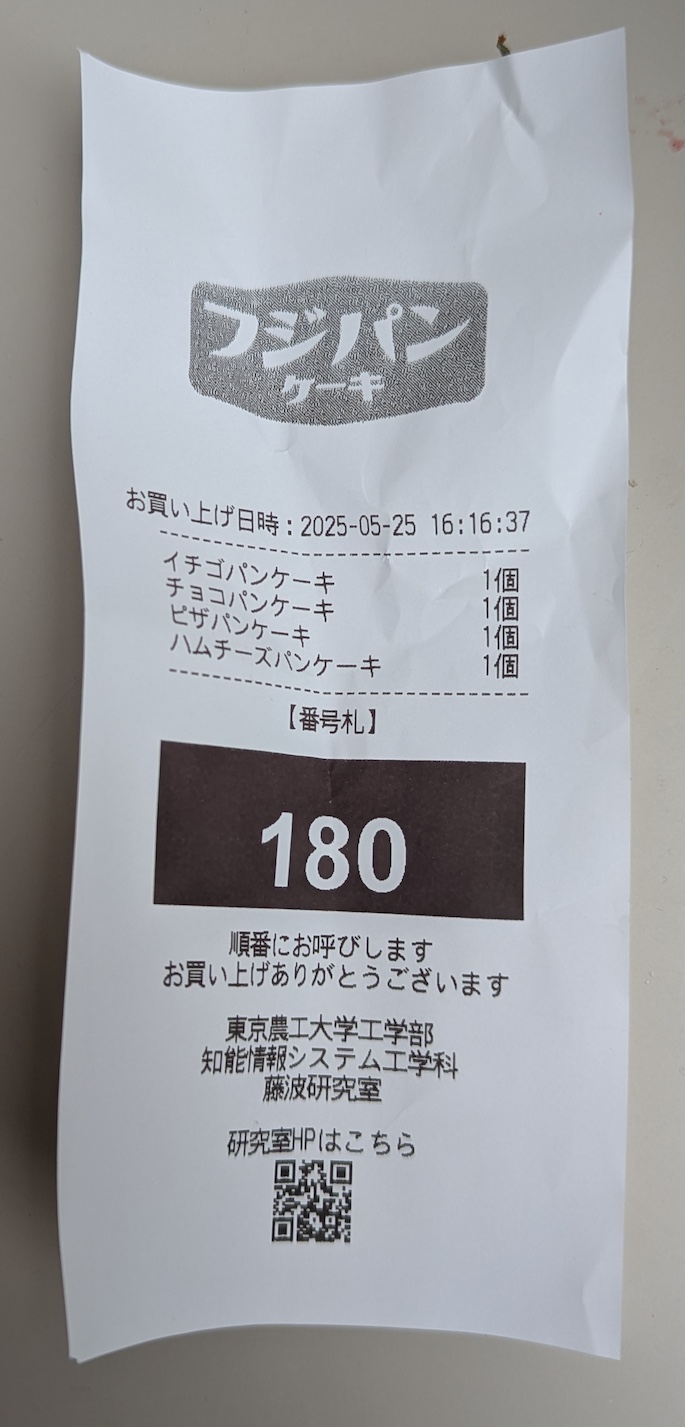

工学部学園祭に模擬店出店しました

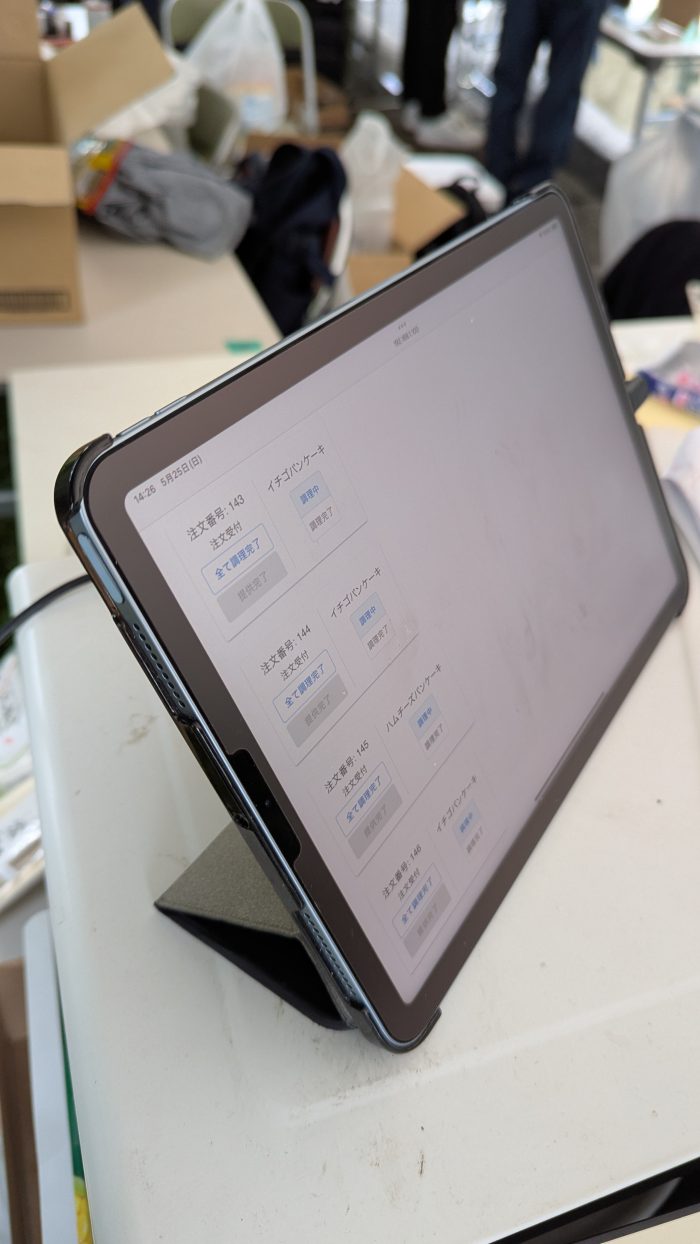

2025年5月25日に開催された工学部学園祭(皐槻祭)に研究室で初めて模擬店出店を行いました.単に売るのはつまらないし,せっかく情報系の研究室の出店なのでオーダー管理システムと待ち時間のミニゲーム的なシステムを研究の合間を縫って開発しました.

オーダー管理は某ファーストフードっぽいレシートを出力する本格的なもので,調理側のタブレット端末とも連携して注文内容や調理状況のなどのやりとりもできるようになっています.もちろん時系列で注文状況も確認できます.

さらに待ち時間の時間つぶしとして4品の人気投票を行うシステムも開発しました.単にタッチ入力では味気ないので,実世界UIと物体擬人化の研究の延長線上で,パンケーキのぬいぐるみを特定の皿に置くことで投票し,その結果を性格が異なるパンケーキャラクタで伝えるようにしました.これは子供から大人まで,特に小さな子供には受けました.

対外発表(UBI86)

M1の時野谷さんと船原君が農工大小金井キャンパスで開かれた情報処理学会ユビキタスコンピューティングシステム研究会第86回研究会にてポスター発表を行いました.

- 時野谷芽来,白神健瑠,井上希凜,森岡怜司,藤波香織.課題取り組み時の心的状態を表す2次元モデルの提案とパズル課題における可視化,情報処理学会ユビキタスコンピューティングシステム研究会 第86回研究発表会(ポスター発表),2025年5月15日.

- 船原優人,藤波香織.マルチモーダルアプローチによる文章要約作業時の困惑推定と汎化性能向上に向けた基礎検討,情報処理学会ユビキタスコンピューティングシステム研究会 第86回研究発表会(ポスター発表),2025年5月15日.

受賞(東京農工大学学生表彰)

博士前期課程2年の志田原萌美さんが,令和6年度 東京農工大学学生表彰(学術研究活動部門(学術研究活動において,特に顕著な業績を挙げ,学会又は社会的に高い評価を受けた場合に授与))を受賞(IEEE GCCE2024でのExcellent Poster Award: Silver Prizeの受賞に対し)し,入学式にて表彰されました.

辻先生ご栄転

知能情報システム工学科助教で本研究室にて2020年11月より研究指導補助にあたっていただいていた辻愛里先生が,2025年4月1日より京都府立大学准教授としてご栄転されました.今後のさらなるご活躍を期待いたします.

保護中: 【OB/OG】2024年度卒業式集合写真

博論・修論・卒論審査会,M1中間発表

★2/21に卒業論文審査会が開かれ5名全員が合格しました.徳安さんが優秀卒業論文賞(学科で8名のうちの1人)を受賞しました.

- 高野耀希:複合現実空間における組み立て作業中の迷い推定とその個人化に関する研究

- 高橋巧三:サービス業における気づきのスキル向上のためのVR訓練の個人化に関する研究

- 時野谷芽来:学習意欲の向上と維持に向けた困惑状態の2次元表現とその推定に関する研究

- 徳安史香:タッチパネル操作時の手と視線の位置関係に着目した自己効力感の測定に関する研究

- 船原優人:マルチモーダルデータを用いた文章要約作業における困惑状態推定に関する研究

★2/17にM1の中間発表が行われました.志田原さんが最優秀発表賞(1位)を受賞しました.

- 志田原萌美:身体と道具の慣性計測によるメンタルワークロード推定に関する研究〜床拭き掃除中のケーススタディ〜

- 長瀬清之助:購買行動における頭部動作と歩行動作に着目した迷い状態の分類に関する研究

- 矢野明日香:ユーザ状態を考慮したVR体験中の実世界アウェアネス支援

★2/14に修論審査会が開かれ4名全員が合格しました.倉田君が発表賞3位となりました.

- 倉田寛大:プログラミング時の自己問題解決を目的とした困惑検出を契機とするアヒル型ロボットに関する研究

- 早川侑花:巧緻性課題実行中の予期的注視に着目した自己効力感の推定に関する研究

- 山中瑞稀:組立作業における仮想エージェントを用いた社会的促進効果に関する研究

- 百合草優伽:同調的で親近感を与える実世界投影型エージェントによる思い出振り返り支援に関する研究

★2/7に寺田憲司君の博士論文公聴会が開催されました.その後の審査を経て博士(工学)の授与が決定しました(3/7).

- 寺田憲司:センシング農業ロボットを用いたマルチモーダル観測による果樹の病害予測に関する研究.

対外発表・受賞(第87回情報処理学会全国大会)

情報処理学会第87回全国大会(立命館大学 大阪いばらきキャンパスにて開催)にて以下の9件の発表を行い,早川さん,百合草さん,倉田君(以上M2),志田原さん(M1),が学生奨励賞を受賞しました(★印).2010年に初めて受賞者が出てから45件(37人)目です.また,2012年度から13年連続受賞です.

- 矢野明日香,辻愛里,藤波香織.VR体験中のユーザ状態を考慮した実世界アウェアネス支援システム,情報処理学会第87回全国大会,7ZN-04,2025年3月15日.

- 高橋巧三,矢野明日香,辻愛里,藤波香織.サービス業における気づきのスキル向上を目指したVRパーソナライズド学習システム,情報処理学会第87回全国大会,6ZE-08,2025年3月15日.

- ★百合草優伽,辻愛里,藤波香織.同調的で親近感を与える実世界投影型エージェントによる思い出振り返り支援システム,情報処理学会第87回全国大会,6ZF-03,2025年3月15日.

- ★倉田寛大,白神健瑠,井上希凜,森岡怜司,大澤隼也,辻愛里,藤波香織.プログラミング時の自己問題解決を目的とした困惑検出を介入契機とするアヒル型ロボット,情報処理学会第87回全国大会,6ZG-01,2025年3月15日.

- ★早川侑花,藤波香織,山本淳一,辻愛里.ペグボード課題実行中の予期的注視に着目した自己効力感推定,情報処理学会第87回全国大会,4ZH-06,2025年3月14日.

- 長瀬清之助,辻愛里,藤波香織.体幹および下肢動作に着目したオプティカルフローによる購買行動時の迷い状態の分類,情報処理学会第87回全国大会,4ZC-08,2025年3月14日.

- 時野谷芽来,倉田寛大,白神健瑠,井上希凜,森岡怜司,大澤隼也,辻愛里,藤波香織.困惑2次元モデルの提案とパズル課題時の生体情報を用いた推定,情報処理学会第87回全国大会,4ZC-07,2025年3月14日.

- ★志田原萌美,辻愛里,藤波香織.慣性データのベクトル量子化を用いた作業時の精神負荷推定〜床拭き掃除のケース〜,情報処理学会第87回全国大会,4ZC-06,2025年3月14日.

- 高野耀希,長瀬清之助,辻愛里,藤波香織.複合現実空間での組み立て作業中の迷いの推定とその逐次個別化,情報処理学会第87回全国大会,4ZC-05,2025年3月14日.

ウェアラブルEXPO出展

2025年1月22日から24日まで東京ビッグサイトで開催されていた第11回ウェアラブルEXPOに大学・研究機関イノベーションフォーラムの一部として出展しました.本研究室からは,行動認識(人間の日常行動,動物の行動),デバイスの身体上の装着位置検出,組み立て作業中の迷い推定システム,日常生活行動における認知負荷推定,VRといった「ウェアラブル」に関する研究全般的な紹介を行いました.

対外発表(HCGシンポジウム2024)

M2の早川さん,百合草さん,M1の矢野さんが石川県金沢市で開催された電子情報通信学会 HCGシンポジウムにて下記の発表を行いました.

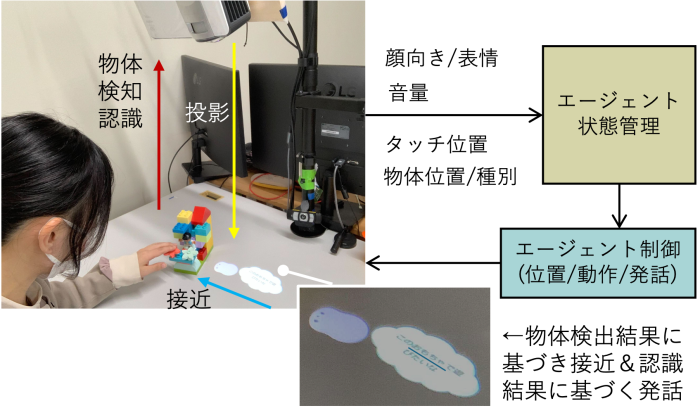

- 百合草優伽,辻愛里,藤波香織.思い出振り返り支援のための同調的で親近感を与える実世界投影型エージェント,電子情報通信学会HCGシンポジウム2024,Paper ID C-1-2, 2024年12月11日.

机の上に投影されるエージェントは,人の顔の向きや表情や周辺の音,タッチに反応して動きや表情を変えます.また,机に置いた物体を認識し,それに合った会話を生成します.実験を通じ,人への反応と物体への反応の両方がエージェントへの親近感を増すことが分かりました.

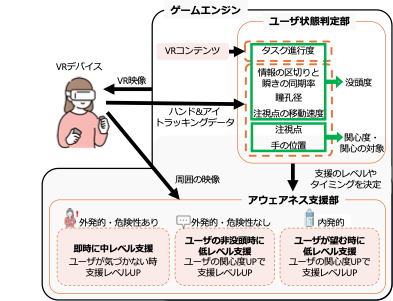

- 矢野明日香,辻愛里,藤波香織.ユーザ状態を考慮したVR体験中の実世界アウェアネス支援システム,電子情報通信学会HCGシンポジウム2024,Paper ID P-1-19, 2024年12月11日.

VR体験中に,人の接近や机の上の飲み物を手に取る,重要なメールの通知,など仮想空間のコンテンツに没入していると実世界との関わりが困難になります.一方,ヘッドセットを外したり,実世界映像を全て透過することは没入を阻害することになります.本研究では没入を極力妨げずに,実世界の様子を伝えて(実世界アウェアネス),関わりやすくする手法を提案しています.本研究では,瞬きの同期率,瞳孔径,注視点,注視点の移動速度,手の位置, タスク進行度などを用いて総合的に判定したユーザ状態から支援のタイミングやレベルを決定するというアウェアネス支援を提案しています.

- 早川侑花,藤波香織,山本淳一,辻愛里.ペグボード課題における自己効力感推定にむけた予期的注視指標の検討,電子情報通信学会HCGシンポジウム2024,Paper ID B-4-2, 2024年12月12日.

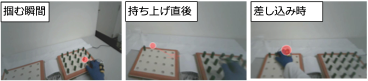

本研究では,作業に対する自信のほどを表す「自己効力感」の定量的な推定にむけ,巧緻性作業において手の動きに先立って目標地点に視線を向ける「予期的注視」に着目しています.ペグボード課題遂行時のデータ収集機器の開発と予期的注視指標の検討を行いました.データ収集のため,手の加速度および指先の圧力を測定する手袋型デバイスと据え置き型のペグ操作検出デバイスを開発しました.上の図は自己効力感が高いケースにおいて,ペグを右側から左側のボードに移動する場合の注視点(赤丸)を表しており,視線がペグを把持 する直前に操作対象のペグから移動先に瞬時に移動しています.一方,自己効力感が低いケースでは,視線は手の動きに先行して移動しながらもペグの移動経路を追従する傾向が窺えました.このように視線と手の動きの位置や時間の関係を定量化することで,自己効力感の定量化が可能になると考えています.

3年生が配属されました

当研究室19期生となる3年生6名が配属されました(岩本純,後藤きらり,田島和展,田中仁,樋泉丈太,村井礼明).

対外発表・受賞(GCCE2024)

博士3年の寺田君,修士2年の倉田君,修士1年の志田原さんが,北九州市で開催されたIEEE Global Conference on Consumer Electronics (GCCE2024)で以下の研究成果の発表を行いました.このうち志田原さんの研究がExcellent Poster Award (Silver Prize)を受賞しました(約160件中の2位).

- Kandai Kurata, Airi Tsuji, and Kaori Fujinami, “Uh-Huh Duch: Self-Problem-Solving Support During Programming Through Interaction with a Doll Duck,” In Proceedings of the 2024 IEEE 13th Global Conference on Consumer Electronics (GCCE 2024), pp. 689-690, 30 October 2024.

- (Silver Prize of Excellent Poster Award) Moemi Shidahara, Airi Tsuji, and Kaori Fujinami, “A Preliminary Study on Mental Workload Estimation Through Movement Analysis Using Inertial Sensors: A Case of Floor Mopping”, In Proceedings of the 2024 IEEE 13th Global Conference on Consumer Electronics (GCCE 2024), pp. 146-147, 29 October 2024.

- Kenji Terada and Kaori Fujinami, “Improving Disease Forecast on Different Farms Using Sensing Agricultural Robot with XAI”, In Proceedings of the 2024 IEEE 13th Global Conference on Consumer Electronics (GCCE 2024), pp. 411-415, 29 October 2024.

論文出版(Poultry Science)

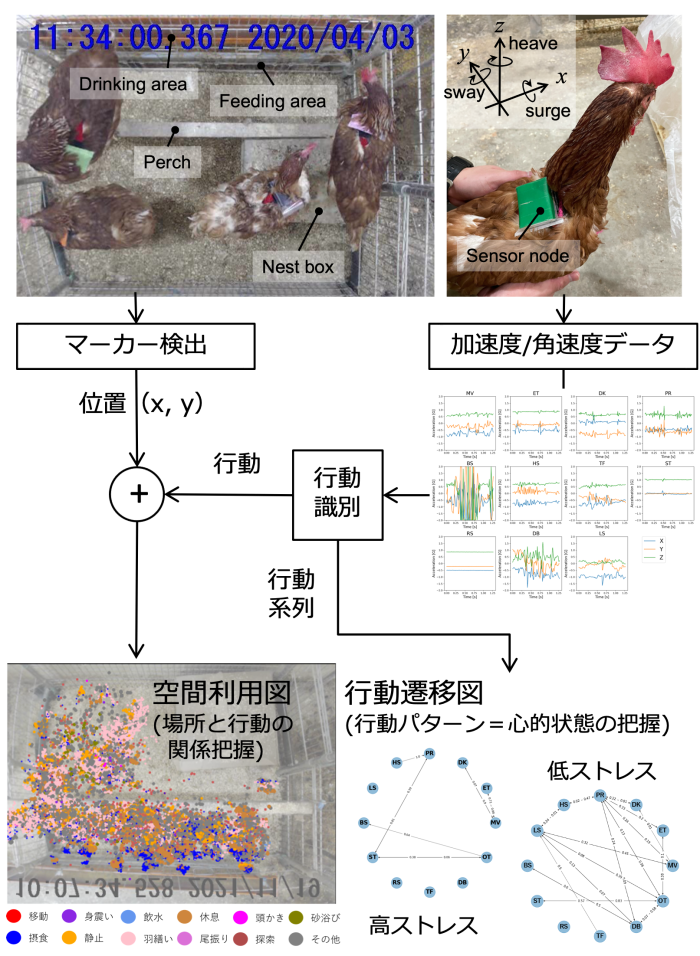

農学部の新村教授の研究グループとのニワトリの行動解析に関する共同研究がPoultry Science誌に採録され,出版されました.

Tsuyoshi Shimmura, Itsufumi Sato, Ryo Takuno, and Kaori Fujinami, “Spatiotemporal Understanding of Behaviors of Laying Hens Using Wearable Inertial Sensors,” Poultry Science, Vol. 102, Issue 12, 2024. [link]

この研究は本研究室の先行研究で実現した装着型の慣性センサ(加速度+角速度センサ)による12種類のニワトリの行動認識結果を利用して,実際に動物行動学者が行動の分析を試みた結果となります.

ニワトリの背中に付けたマーカー検出による位置計測と行動認識結果を画像上にマッピングして「空間利用図」を作成することで「(いつ)どこで,どのような行動が発生するか」という行動とその発生場所の関係を視覚的に理解しやすくなります.

また,認識された短時間(約1秒)の行動の移り変わりをノードを行動,エッジを遷移確率とする「行動遷移図」として表現することで,1日の中での行動の移り変わり方を視覚的に捉えることが可能になります.従来は実験者が録画したビデオを目視で時間をかけて読み取るため多くの時間を要したり,その解決のためにサンプリングされた区間を読み取ることで稀で重要な遷移を見落とすなどの問題がありました.しかし,コンピュータにより大量の情報を瞬時に処理できるようになることで,これまでと質的に異なる解析が可能になると期待されます.この行動遷移図の解析は行動を記号化できれば,あらゆる行動パターンの解析に応用できるため,今後は野生動物や人間の行動パターン解析への応用も検討していきます.

対外発表(FIT2024)

M1の志田原萌美さんが以下の論文発表を行いました.

志田原萌美,早川侑花,辻愛里,藤波香織.人とモノへの装着型センサを用いた行動計測によるメンタルワークロード推定〜床拭き掃除のケース〜,第23回情報科学技術フォーラム(FIT2024)予稿集,pp. 243-248, 2024年9月5日.

作業中の認知負荷(メンタルワークロード;MWL)が高いことで当該作業におけるヒューマンエラーの発生可能性が高まったり,負荷を高める要因による心身不調の発生,肥満や疲労・睡眠障害リスクの増大などの問題が生じます.本研究では,日常の作業中のMWL推定を目的とし,その一例としてフローリングワイパー掛けを取り上げました.頭部,手首,モップの柄に加速度/角速度センサをとりつけ,それらから得られる慣性データを入力,認知負荷の指標として用いられることが多いNASA-TLXおよび精神疲労尺度の主観評価値をそれぞれ出力とする回帰モデルを教師付機械学習により構築しました.そして,有効なセンサ取り付け部位が手首であること,個人特化型の回帰モデルを用いた場合には,最大可能誤差100のうち平均絶対誤差10.0以下になることを確認しました.

研究室旅行@伊豆

2019年度以来,コロナ禍で中断していた研究室合宿を5年ぶりに実施しました.2泊3日で,伊豆高原に出かけ親睦を深めました.

対外発表(ICCHP2024)

M2の早川侑花さんが以下の国際会議発表を行いました.

Yuka Hayakawa, Kaori Fujinami, Junichi Yamamoto, Airi Tsuji, “Self-efficacy Measurement Method Using Regression Models with Anticipatory Gaze for Supporting Rehabilitation”, In Proc. International Conference on Computers Helping People with Special Need 2024 (ICCHP 2024), LNCS Vol. 14751, Springer, Cham., 8-12 July, 2024. [link]

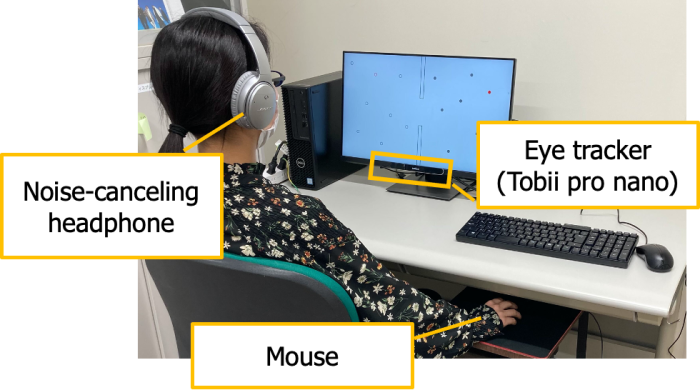

実験環境(回転変換マウス,視線計測装置)

手の精緻な動作が求められるタスクにおいて,それが達成できると信じる度合い(自己効力感)とが高くなるほど,視線が手に先行して動く性質(予期的注視)を利用して,自己効力感の定量化を目指した研究です.初期検討として,PC上で行う迷路とパズルの2つの課題に対して,マウスポインタとディスプレイ上の注視点座標を取得して,多変数回帰モデルを機械学習により作成して評価しました.マウスの難しさを制御するために意図的に動作方向とカーソル移動方向を変化させたマウス(回転変換マウス)を開発して利用しました.リハビリテーションにおけるペグボード訓練への適用を目指し,現在は研究を進めています.