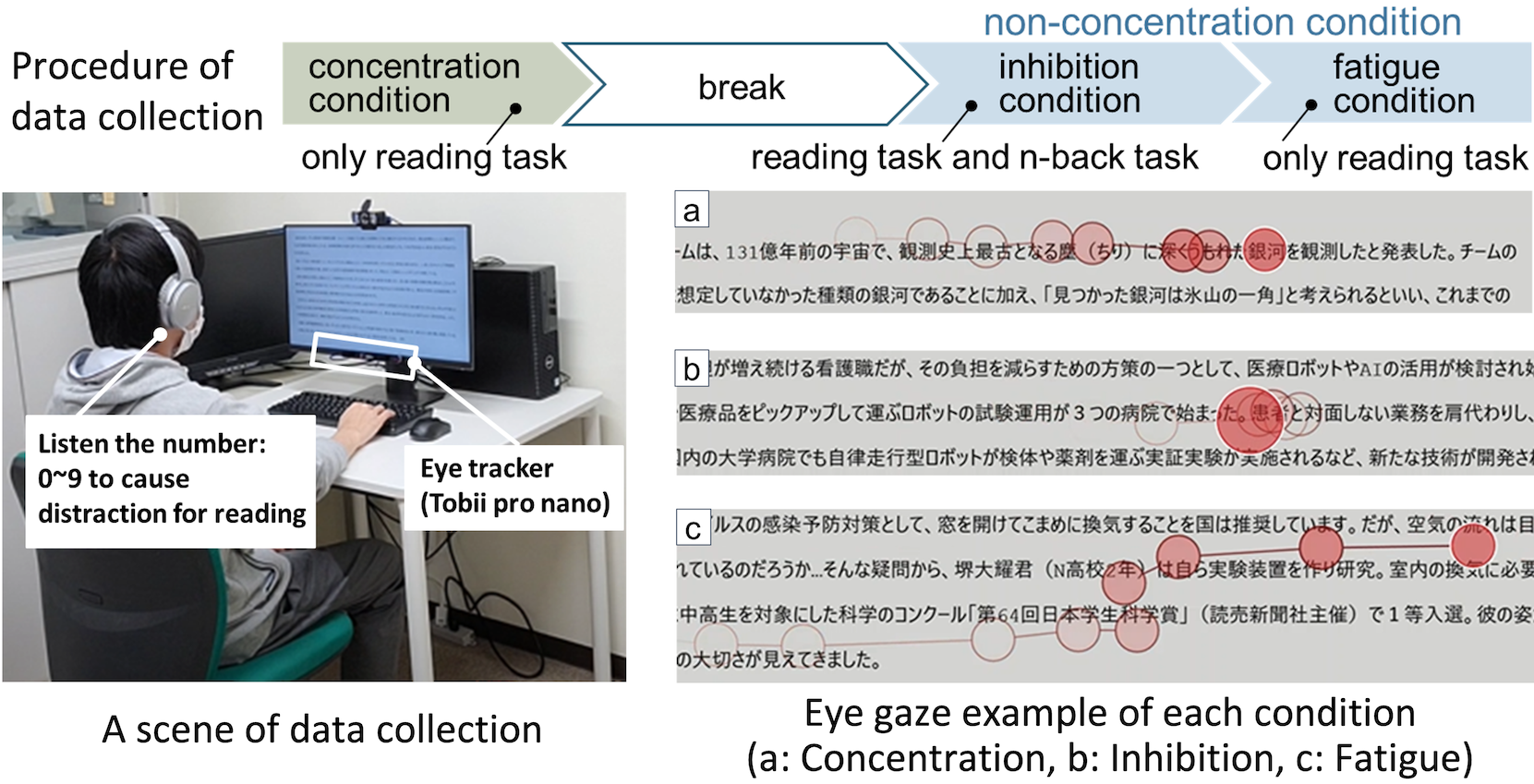

修士2年の田中さんが視線活動による人間の集中状態識別の研究に関して以下の発表を行いました.

Saki Tanaka, Airi Tsuji, and Kaori Fujinami, “Eye-Tracking for Estimation of Concentrating on Reading Texts”, In Proc. of the 5th International Conference on Activity and Behavior Computing (ABC2023), 8 September 2023.